Costruire App Multimodali con GPT-4o

OpenAI ha appena annunciato GPT-4o, un nuovo modello di punta capace di ragionare in tempo reale su audio, immagini e testo. Questo modello, soprannominato “omni” per le sue capacità multimodali, rappresenta un passo significativo verso un’interazione più naturale tra umani e computer. Secondo OpenAI, GPT-4o “accetta come input qualsiasi combinazione di testo, audio e immagini e genera output in qualsiasi combinazione di testo, audio e immagini”.

Esiste una libreria open source che consente di utilizzare GPT-4o nei tuoi progetti Python. In questo articolo, ti mostrerò come utilizzarla insieme a GPT-4o tramite l’API di OpenAI per costruire app multimodali.

Installazione

Per prima cosa, installa l’ultima versione del client Python di The Pipe tramite pip:

pip install thepipe_api –upgrade

Percorreremo i passaggi per estrarre tutto il contenuto multimodale da diverse fonti, preparare l’input per GPT-4o, inviarlo al modello per l’elaborazione e ottenere i nostri risultati.

Caratteristiche Principali di GPT-4o

Prima di entrare nel codice, vediamo perché dovremmo usare GPT-4o rispetto ai modelli precedenti come GPT-4-turbo:

- Input e Output Multimodali: GPT-4o può gestire input di testo, audio e immagini e generare output in uno qualsiasi di questi formati.

- Elaborazione in Tempo Reale: Il modello può rispondere agli input audio in appena 232 millisecondi, rendendolo adatto per applicazioni in tempo reale.

- Prestazioni Migliorate: GPT-4o eguaglia le prestazioni di GPT-4 Turbo sul testo in inglese e sul codice, con miglioramenti significativi nelle lingue non inglesi, nella comprensione visiva e audio.

- Costo e Velocità: GPT-4o è il 50% più economico e 2 volte più veloce di GPT-4 Turbo, con limiti di velocità 5 volte superiori.

Utilizzo di GPT-4o con Immagini e Video

Passo 1: Estrarre Contenuti

Per utilizzare efficacemente GPT-4o, dovrai estrarre contenuti dalle tue fonti. Questo può essere fatto utilizzando The Pipe API, che può gestire vari tipi di file e URL, estraendo testo e immagini in un formato comprensibile per GPT-4o.

Ad esempio, se stessimo analizzando un discorso basato su un articolo scientifico, potremmo combinare le due fonti per fornire un input completo a GPT-4o:

from thepipe_api import thepipe

# Extract multimodal content from a PDF

pdf = thepipe.extract("path/to/paper.pdf")

# Extract multimodal content from a YouTube video

vid = thepipe.extract("https://youtu.be/dQw4w9WgXcQ"

Passo 2: Preparare l’Input per GPT-4o

Ecco un esempio di come preparare il prompt di input semplicemente combinando il contenuto estratto con una domanda dell’utente:

# Add a user query

query = [{

"role": "user",

"content": "Which figures from the paper would help answer the question at the end of the talk video?"

}]

# Combine the content to create the input prompt for GPT-4o

messages = pdf + vid + query

Passo 3: Inviare l’Input a GPT-4o Con l’input preparato, puoi ora inviarlo a GPT-4o utilizzando l’API di OpenAI. Assicurati di avere il tuo OPENAI_API_KEY impostato nelle variabili d’ambiente.

from openai import OpenAI

# Initialize the OpenAI client

openai_client = OpenAI()

# Send the input to GPT-4o

response = openai_client.chat.completions.create(

model="gpt-4o",

messages=messages,

)

# Print the response

Tutto fatto!

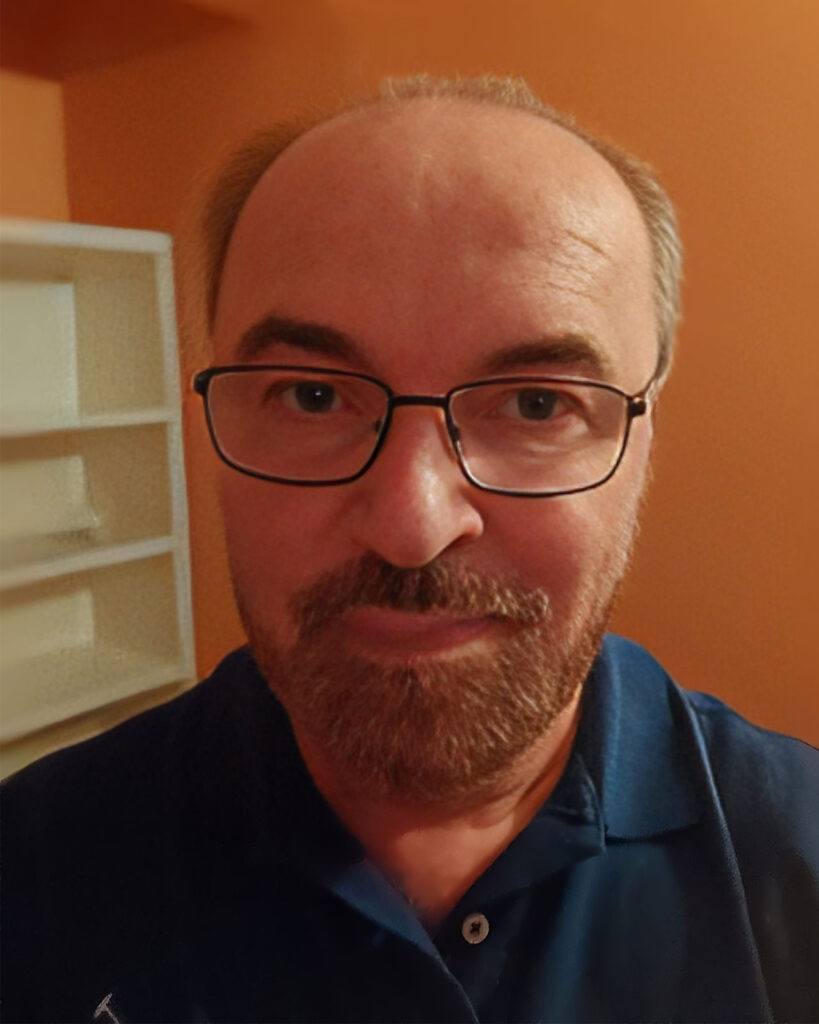

Gabriele Ferrari

Via Cesare Costa,88

41123 – Modena

Nato il 10/06/1968

Tel. +39 3357682392

P.IVA 03615520362

E-mail: gabriele@gabrieleferrari.net

Web Designer, Digital Project Manager, Esperto di WordPress, Sviluppatore Web, Esperto Certificato di Google Ads, Social Media Manager e Graphic Designer attualmente lavora come libero professionista. Fornisce servizi quali consulenza, sviluppo di siti web, SEO e pubblicità online, marketing sui social media, grafica e sviluppo di app mobile per aziende e privati. Precedente esperienza come Web Project Manager e Social Marketing Manager in importanti agenzie web, nonché Family Banker e Team Manager nel settore dei giochi. Laureato presso la facoltà di Ingegneria Elettronica dell’Università di Bologna.